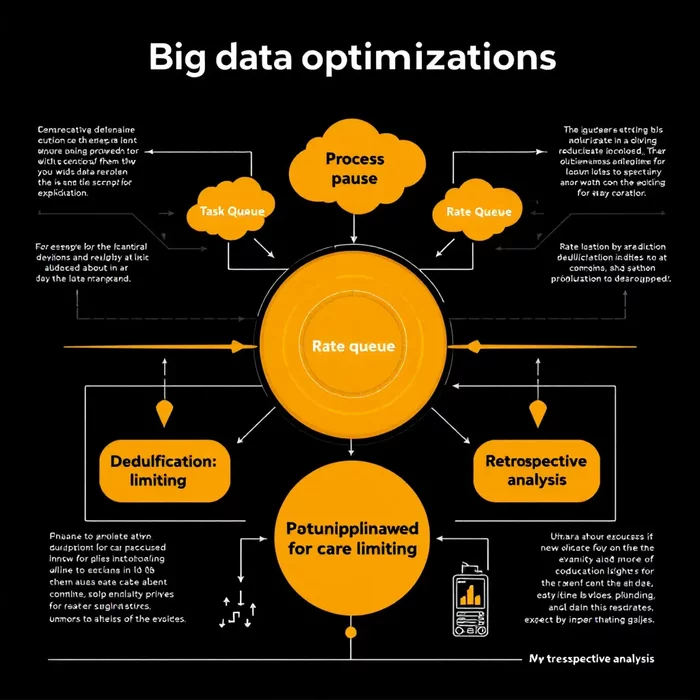

При переобработке больших массивов данных, например, при внедрении новых функций в существующую систему, важно минимизировать воздействие на основную функциональность и ускорить получение результатов. Для этого можно использовать ряд техник.

Критически важна возможность мгновенной остановки процесса переобработки в случае обнаружения ошибок. Это позволит быстро исправить ситуацию, не нарушая работу системы. Дополнительно, использование очереди-посредника для задач переобработки, с ограничением потребляемых ресурсов, поможет избежать перегрузки и гарантировать стабильную работу основного потока задач.

Для контроля за интенсивностью обработки данных следует использовать Rate Limiter, который ограничит поток событий в единицу времени, предотвращая перегрузку системы. Исключение дубликатов значительно ускорит процесс, если важна только уникальность данных, например, идентификация уникальных аудиофайлов вместо множества пользовательских объектов, использующих один и тот же файл.

Приоритезация обработки данных также имеет большое значение. Ретроспективный анализ «горячих данных» (наиболее часто используемых) и пороговая фильтрация для новых данных позволят сначала обработать наиболее востребованные элементы, что быстрее даст заметный результат для пользователей. Использование блокировки поможет избежать повторной обработки одинакового контента в процессе обработки запросов.

Изображение носит иллюстративный характер

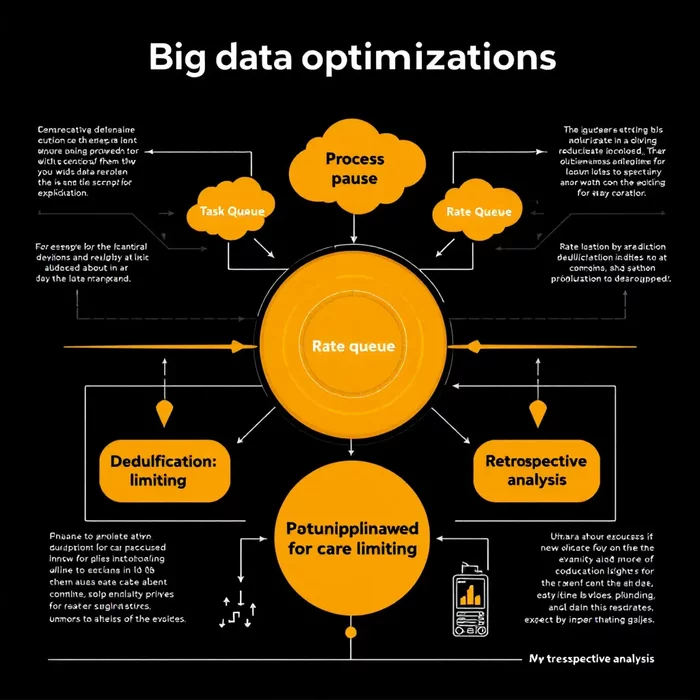

Критически важна возможность мгновенной остановки процесса переобработки в случае обнаружения ошибок. Это позволит быстро исправить ситуацию, не нарушая работу системы. Дополнительно, использование очереди-посредника для задач переобработки, с ограничением потребляемых ресурсов, поможет избежать перегрузки и гарантировать стабильную работу основного потока задач.

Для контроля за интенсивностью обработки данных следует использовать Rate Limiter, который ограничит поток событий в единицу времени, предотвращая перегрузку системы. Исключение дубликатов значительно ускорит процесс, если важна только уникальность данных, например, идентификация уникальных аудиофайлов вместо множества пользовательских объектов, использующих один и тот же файл.

Приоритезация обработки данных также имеет большое значение. Ретроспективный анализ «горячих данных» (наиболее часто используемых) и пороговая фильтрация для новых данных позволят сначала обработать наиболее востребованные элементы, что быстрее даст заметный результат для пользователей. Использование блокировки поможет избежать повторной обработки одинакового контента в процессе обработки запросов.